News du mercredi 02 octobre 2013

Panne iTunes chez Apple

Depuis environ 19h30 de nombreuses personnes ne peuvent accéder à l'iTunes Store après avoir aussi connu plus brièvement des problèmes avec FaceTime et Game Center.

Apple, optimiste, annonce que les problèmes sont réglés, ce qui n'est toutefois visiblement pas encore le cas, tout du moins pour accéder à iTunes.

Pour suivre les pannes d'Apple:

http://www.apple.com/fr/support/systemstatus/

iCloud: Le retour du push mail en Allemagne

Voilà 19 mois qu'Apple avait été obligé de désactiver le push mail de ses services en Allemagne suite à un litige de brevet avec Motorola.

De l'avis des experts ce brevet n'aurait jamais dû être accordé et Apple avait quand même été obligé de mettre sous séquestre 132 millions de dollars pour prévoir une éventuelle défaite.

Entretemps et devant la faiblesse du dossier d'accusation l'affaire a été abandonnée. Elle aura quand même porté préjudice aux consommateurs allemands pendant plus d'un an et demi.

Un bug entre iOS 7 et certaines applications

Un bug est apparu sous iOS 7 avec certaines applications anciennes, dont celle de MacBidouille. Malgré le passage en tâche de fond de ces applications, elles continuent à consommer de grandes quantités de bande passante, énormément par rapport à leur usage.

Pensez à surveiller votre consommation et à réellement quitter ces applications une fois que vous en avez terminé avec elles en les retirant de la liste après avoir pressé deux fois le bouton de façade de l'iPhone.

Nous allons aussi vite que possible régler ce problème pour la nôtre.

Mises à jour SMC pour de nombreux portables

Apple propose des mises à jour SMC pour les MacBook Pro Retina de 2012, les MacBook Pro mi-2012 et les MacBook Air de mi-2012 et 2013.

Elles règlent un bug de batterie qui fige les machines quand la quantité d'énergie restante est proche de la fin, autour de 1%.

L'ARCERP critique sur les annonces de Free

Free hier a présenté sa nouvelle carte de ses services.

Pour le gendarme des télécommunications, annoncer 100 Mbits/s sur le VDSL2 est à la limite du mensonger, ce débit étant impossible à atteindre dans des conditions réelles. Il en va de même pour les débits de la fibre, certes atteignables mais qui dépendent plus que jamais de tout le reste d'internet pour être utilisables. Or, il n'y a qu'à essayer de voir une vidéo HD sur Youtube depuis une connexion Free pour comprendre que disposer d'une ligne capable d'un tel débit n'est pas forcément synonyme de confort de lecture.

En fait, il semble que Free fasse la même chose qu'à ses débuts. En proposant des gros débits ou des énormes pages perso l'opérateur incite ses clients à mettre en ligne des données qui seront utilisées par les clients des autres opérateurs. Cela va déséquilibrer en faveur de Free les liens de peering, ce qui fait que ses concurrents vont devoir lui payer plus d'argent et d'une certaine manière financer ses infrastructures.

iOS 7: Apple va régler le problème d'iMessage

Depuis le passage à iOS 7 nombre de personnes sont confrontées à des problèmes avec les iMessages. Ces derniers refusent de partir ou n'arrive jamais, de manière assez régulière. Le Wall Street Journal rapporte qu'Apple est au courant de ce problème et travaille dessus. Une nouvelle mise à jour iOS 7 sera prochainement disponible et viendra régler ce problème fort ennuyeux.

En attendant, il semble que réinitialiser les réglages réseau et/ou désactiver et réactiver iMessage règle le problème au moins temporairement.

Google satisfait l'Europe, mais pas la CNIL

Depuis plusieurs années, Google et la Commission Européenne sont en conflit, la seconde reprochant au premier diverses pratiques déloyales, visant principalement à profiter de la popularité de son moteur de recherche pour favoriser ses produits dans d'autres secteurs.

Après que la Commission, représentée par le commissaire à la Concurrence Joaquin Almunia, a menacé Google d'initier une procédure de sanction, ce dernier a apporté diverses propositions de modification de la présentation des résultats dans son moteur de recherche pour tenter d'apaiser la situation. Des propositions qui ont fait mouche, puisqu'elles semblent satisfaire Joaquin Almunia, qui a parlé "d'amélioration significatives" qui vont permettre à Google et à la CE de continuer d'avancer paisiblement sur ce dossier.

On devrait donc voir apparaitre à l'avenir diverses modifications dans la présentation des résultats. Par exemple, Google devrait distinguer les services qui lui appartiennent dans les résultats, tout en les accompagnant systématiquement de trois services concurrents. Certaines clauses d'exclusivité de ses contrats de régie publicitaire devraient également être éliminées.

Si Google semble parti pour s'en tirer plutôt bien sur l’accusation d'abus de position dominante en Europe, le géant du web n'en a toutefois pas fini avec les ennuis avec les autorités. Par exemple, en France, le ton est encore monté d'un cran entre Google et la CNIL. Après avoir mis Google en demeure de revoir sa politique de gestion des données personnelles, sans succès, la CNIL a en effet mis en route une procédure de sanction. Malheureusement, si la CE a réussi à faire plier Google, la force de frappe de la CNIL risque d'être bien insuffisante, l'amende encourue par Google n'étant pour l'instant que de 150 000€, une goutte d'eau par rapport à son chiffre d'affaires.

Où l'on reparle de pile à combustible

Voilà un petit moment que l'on avait plus parlé de pile à combustible. Engadget a eu l'occasion d'en croiser une lors du salon Createc.

Ce prototype fonctionnel pourrait être commercialisé prochainement et intéressera probablement ceux qui sont obligés de s'éloigner pour de très longues durées de toute source d'électricité. Ils devront toutefois balader avec eux des cartouches contenant des produits inflammables destinés à produire de l'hydrogène, le gros défaut de ces piles à combustible.

SFR passe aussi à la fibre à 1 Gbit/s

Hier Free a bousculé les lignes et la concurrence en annonçant que ses clients fibrés auraient droit à un débit de 1 Gbit/s / 200 Mbits/s.

SFR vient de suivre et a annoncé que les clients Fibre 300 Mbits/s pourront basculer sur simple demande à ces nouveaux débits s'ils y sont éligibles. L'opérateur a aussi annoncé sa transition vers le VDSL2.

Free a donc joué encore une fois son rôle de trublion des télécommunications. Toutefois, la société est loin d'être en position de force sur la fibre optique et elle n'a qu'un potentiel de clients très limité par rapport à ses concurrents. Il est donc possible que son annonce ne soit à double tranchant et que nombre de clients lassés d'attendre la Fibre par Free n'aillent voir ailleurs.

Il est toutefois aussi possible que Free ait justement fait exprès de lancer cette annonce justement pour obliger ses concurrents à s'aligner ce qui les obligera à investir massivement pour tenir ces débits autant que possible et donc devenir moins compétitifs.

Ces deux annonces sont aussi l'occasion de rappeller la différence technique entre le réseau fibre de Free (P2P) et ceux des autres opérateurs (GPON), car cette différence pourrait commencer à se faire sentir avec des offres à 1 Gbit/s. En P2P, il y a une fibre dédiée du NRO (Noeud de Raccordement Optique, le dernier équipement actif des opérateurs avant l'abonné) vers chaque prise murale chez les abonnés, tandis qu'en GPON il y a une unique fibre, généralement à 2.4 Gbit/s, qui part du NRO vers des groupes d'abonnés. Une même fibre peut ainsi être partagée entre un maximum de 64 abonnés. Il est donc assez évident qu'en offrant à chaque abonné un débit de 1 Gbit/s, la fibre 2.4 Gbit/s sera vite saturée, et les abonnés ne pourront donc espérer bénéficier de ce débit maximal qu'en période creuse.

Notons également que l'absence de goulet d'étranglement entre l'abonné et le NRO ne garantit tout de même pas non plus de pouvoir bénéficier d'1 Gbit/s en pratique. D'abord, parce que le NRO lui même est raccordé au réseau avec une liaison relativement "lente" par rapport au total des lignes des abonnés (généralement de l'ordre de 10 Gbit/s), ensuite parce que les interconnexion entre le réseau du FAI et les autres réseau ne sont pas forcément suffisament performantes (inutile d'espérer un accès plus fluide à YouTube suite à la hausse de débit offerte par Free, comme le rappelle l'ARCEP dans un communiqué), et enfin parce que les serveurs distants auxquels l'abonné se connecte ont rarement une telle bande passante, ils disposent généralement d'une connexion entre 100 Mbit/s et 10 Gbit/s, partagée entre tous les utilisateurs du service.

Cray fait aussi du GPGPU

Tout le monde a entendu parler de la société Cray, qui depuis 1972 fabrique des supercalculateurs hors norme destinés aux laboratoires de recherche et autres administrations.

La société a dévoilé ses nouveaux produits, les Cray XC30, qui marquent une rupture par rapport à leurs prédécesseurs.

Ces appareils sont en effet les premiers dans lequels on peut installer des cartes Xeon Phi d'Intel ou des Tesla de Nvidia afin d'en améliorer la puissance tout en maîtrisant au mieux la consommation.

C'est la preuve flagrante de la place toujours plus importante du GPGPU dans les claculs intensifs même si l'on ne peut en parler réellement dans ces termes pour les Xeon Phi. En effet, ce sont des cœurs x86 et pas des unités de traitement graphiques mais l'on peut se permettre cette analogie étant donné que le projet Xeon Phi est né de l'échec du projet Larrabee d'Intel, qui voulait remplacer les cartes graphiques par de très nombreux cœurs x86 simples.

Cray déclinera ces XC30 dans de très nombreuses configurations de puissance variable. Si vous êtes tentés, le modèle de base doté d'un refroidissement à air sera facturé la bagatelle de 500 000$. Nous ignorons s'il sera possible de le transformer en Hackintosh mais avec un tel tarif les futurs Mac Pro sembleront presque donnés :)

Seagate va faire une démonstration d'un disque dur HARM

On parle depuis plusieurs année de la technologie HARM, Heat Assisted Magnetic Recording, qui utilise un système de chauffage localisé du plateau pour augmenter de manière considérable la densité de données stockées.

En résumé, les plateaux ont des pistes beaucoup plus proches. Pour éviter que la tête lors des écritures ne modifie la magnétisation des pistes contiguës les particules magnétiques sont noyées dans un substrat qui est figé à température ambiante. Pour les orienter et écrire des 0 ou des 1 il faut chauffer très localement le substrat, ce que fait un laser. Dès que la piste refroidit les particules sont de nouveau figées et conservent leur orientation et donc les données.

Seagate a annoncé qu'un disque HARM fonctionnel sera présenté lors du Salon Ceatec qui démarre aujourd'hui. Il s'agit d'un disque dur 2,5" tournant à 10 000 tours par minute et destiné aux marchés professionnels. Selon Seagate, cette technologie va permettre d'atteindre la capacité de 20 To dans un disque dur d'ici 2020.

On attend avec impatience de connaître les performances de ces disques. En effet, ajouter un laser au système d'écriture est un défi technique qui pourrait avoir une forte incidence négative sur les débits en écriture et surtout sur les temps d'accès.

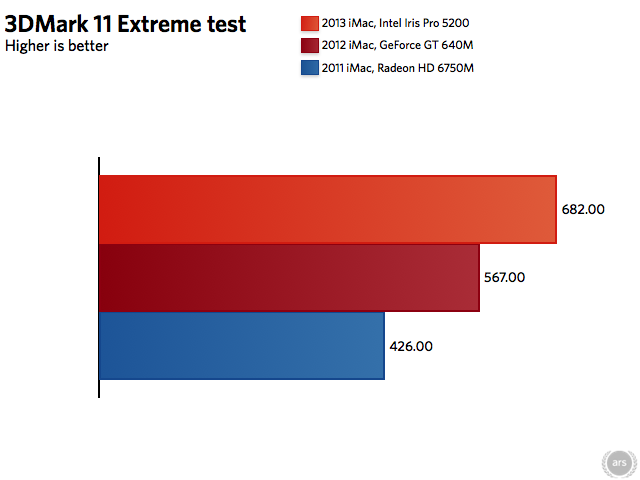

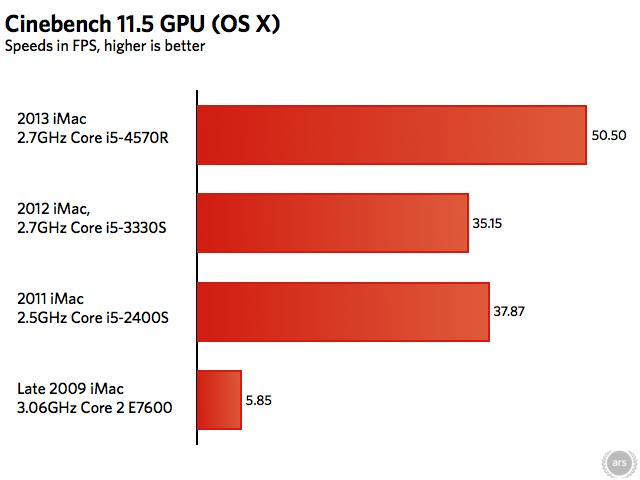

L'Iris Pro 5200 en a réellement sous le capot

Les modèles d'entrée de gamme des nouveaux iMac sont par défaut dotés de la partie graphique intégrée d'Intel, l'Iris Pro 5200. ARS Technica, qui a testé ces machines, a constaté combien cette solution était performante par rapport à tout ce qu'Intel nous avait proposé jusqu'à maintenant.

Aussi bien sous Windows que sous OS X cette solution graphique fait nettement mieux que la Geforce GT 640M et arrive au niveau de la GT650M dont sont aussi dotés les MacBook Pro Retina.

Dans ces conditions il est fort possible qu'Apple propose sur les futurs modèles 15" de ces Retina ce seul Iris Pro sans autre partie graphique dédiée, tout du moins sur les modèles d'entrée de gamme. Ce serait une grosse économie sur le design et les composants et permettrait un gain de performances également, la partie graphique d'Intel étant économe en énergie.

Il est toutefois possible qu'Apple gardera sur les modèles haut de gamme une partie graphique dédiée dotée de beaucoup de VRAM et destinée aux clients les plus exigeants.

Pour en revenir aux iMac 2013, l'article confirme que le gain de performances de la partie CPU reste faible, que le Wi-Fi 802.11 ac fonctionne encore en deçà des attentes et surtout que sans Fusion Drive cette machine est fortement handicapée par rapport à ce qu'elle peut donner avec, surtout sur le modèle 21,5" doté d'un disque dur 2,5" encore plus lent. C'est clairement dans ce cas une hérésie que de ne pas lui installer un Fusion Drive, ou éventuellement un SSD si l'on ne veut pas payer pour cette coûteuse option.

Etes-vous tenté par le nouveau Mac mini M4 ?

Total des votes : 5761