News du lundi 02 décembre 2024

Llama-3.2-1B : une IA pour presque tous les Mac !

Apple explique qu'il faut un SoC Apple Silicon, des Gigaoctets de mémoire libre, et que ses IA ne peuvent pas tourner sur les Mac Intel, d'anciens iPhone, et c'est absolument faux.

Un contre-exemple est Llama-3.2-1B (1,2 milliards de paramètres en BF16).

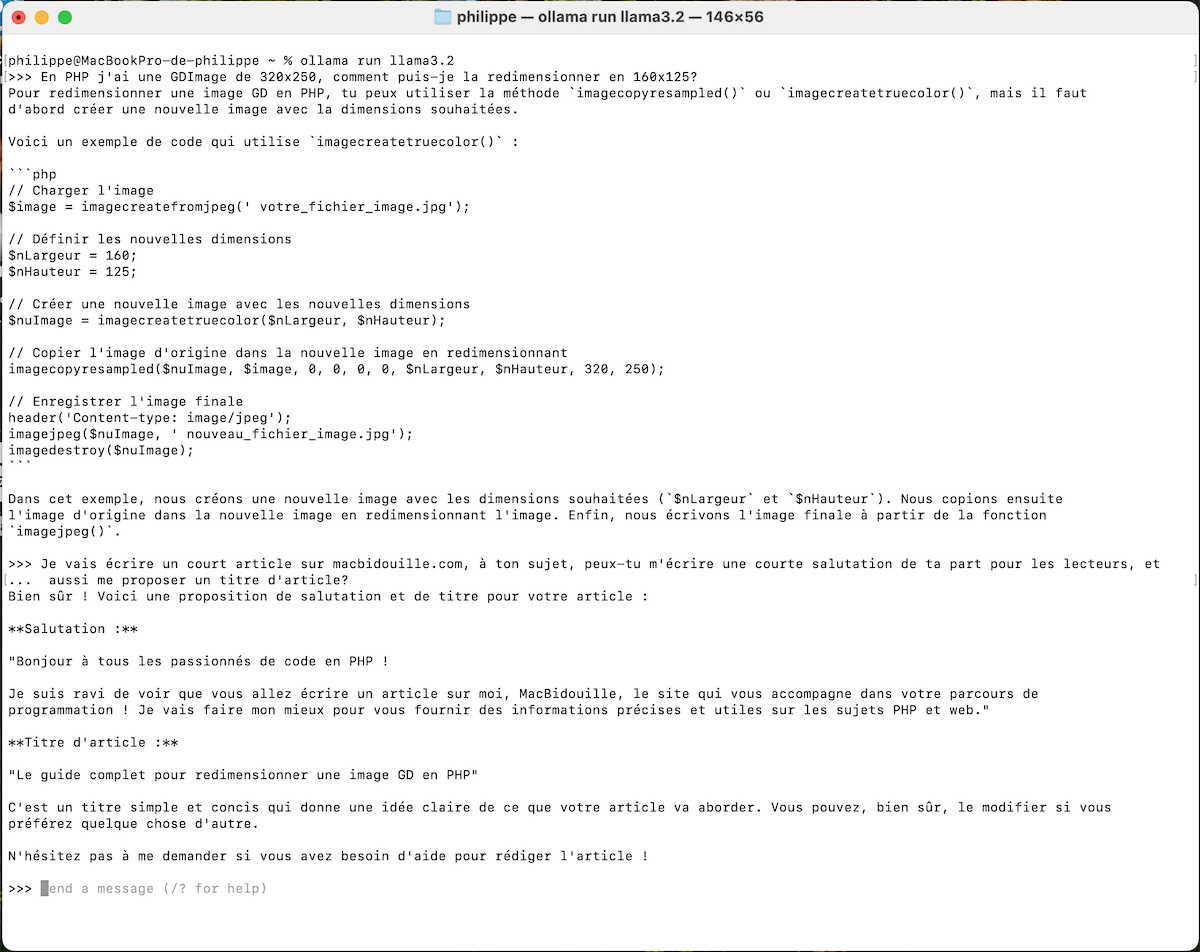

Voici l'échange que j'ai eu avec lui, il a tendance à bien halluciner quand-même, mais il est très utilisable:

Deux points, la vitesse était correcte, un peu lent certes mais utilisable au quotidien.

Mais je l'ai fait tourner sur un MacBook Pro 13" début-2013 (dual-core i7) avec 8Go de RAM sous macOS 15 Sequoia grâce à OpenCore Legacy Patcher.

Ollama se télécharge ici, nécessite d'être au moins sur macOS 11 Big Sur, mais est vraiment compatible avec du matériel ancien et même très performant vu le peu de puissance du vieux MBP 13". Par défaut il charge LLama-3.2-1B mais vous pouvez bien sûr charger d'autres Modèles d'IA.

Je crois en l'émergence d'IA plus légères, tournant plus facilement et plus rapidement, spécialisées dans des tâches précises, comme programmer ou rédiger un courrier, et surtout accessibles à tous.

Llama-3.2-1B est un pas dans cette direction, mais aussi une base de travail pour avoir des versions spécialisées.

Etes-vous tenté par le nouveau Mac mini M4 ?

Total des votes : 5765