Clustering dernière partie

Présentation des méthodes de clustering

Systèmes de gestion (suite) :

3.2.2 Virtualisation [5]Comme nous l'avons vu, la clusterisation peut induire de nombreuses difficultés en terme de gestion des noeuds. Ceci rend complexe l'allocation dynamique des ressources, en fonction des diverses besoins des programmes distribués tournant sur le serveur.

Dans cette optique a été introduit le concept de virtualisation. Il a pour but de casser la granularité du cluster en permettant de consolider plusieurs serveurs en une seule entité de manière à simplifier et à gérer dynamiquement les tâches exécutées. Il est à l'inverse aussi possible d'éclater le serveur selon les besoins et les contraintes spécifiques du moment. La virtualisation permet donc de faire face à des charges d'intensité très variable au cours du temps en regroupant ou en divisant la puissance des différents noeuds et de l'utiliser selon la demande au travers de serveurs virtuels.

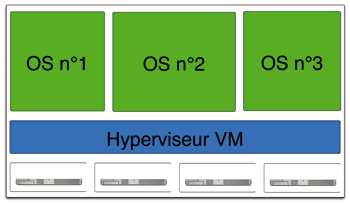

Fig. 3.3 Virtualisation des ressources d'un cluster

Il existe deux méthodes de consolidation :

- regroupement des différentes tâches applicatives tournant sur différents serveurs au sein d'un même OS

- regroupement des différents serveurs dans une seule et même machine "virtuelle"

La première est une forme de load-balancing courante dans les cluster HS, tandis que la seconde devient un véritable partitionnement logique ( notion de "partitioning"). Au contraire du partitionnement physique (serveurs discrets disposant chacun d'un OS regroupés dans une seule entité), le partitionnement logique permet la mutualisation des ressources matérielles. Celles-ci (processeurs, mémoires, disques, ... ) sont alors mises en commun.

Le lien entre les ressources virtuelles et les ressources réelles se fait par l'intermédiaire d'un superviseur (z/VM chez IBM). Celui-ci est une forme d'OS de bas niveau qui joue le rôle de machine virtuelle. Les opérations sont complètement transparentes pour les systèmes d'exploitation et il n'y a pas de fusion applicative. La machine virtuelle va permettre de simuler les liaisons réseaux entre les différents machines, ce qui apporte un gain notable en terme de vitesse de transmissions (liaisons mémoire à mémoire). De plus lorsqu'un serveur virtuel est inactif, il ne bloque pas les ressources physiques, qui sont utilisables par un autre serveur virtuel actif. La complexité des architectures des serveurs physiques peut être arbitrairement compliquée, les systèmes d'exploitation n'ont pas besoin de la gérer puisque le superviseur s'en charge. Nous touchons l'informatique "On-Demand".